関連記事

OKIとNEDO、深層学習モデルの軽量化技術を開発 高度AIの小型デバイス搭載に期待

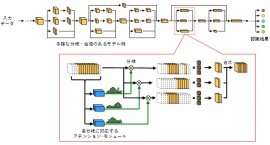

今回開発されたモデル軽量化技術の概要(画像:OKIの発表資料より)[写真拡大]

沖電気工業(東京都港区、以下「OKI」)と新エネルギー・産業技術総合開発機構(神奈川県川崎市、以下「NEDO」)は9日、さまざまな分岐・合流を持つCNN(畳み込みニューラルネットワーク)モデルの軽量化技術を開発したと発表した。認識性能を低下させることなく、メモリー使用量や消費電力を低減でき、スマートフォンなどの小型デバイスに高度なAIを搭載することが可能になると期待される。

【こちらも】東芝と理研、コンパクトDNNでAIを高速化 エッジでの推論は加速するか

人間の脳の仕組みを模したニューラルネットワークをベースにしたディープラーニング(深層学習)モデルは、多層化することで画像や音声などの認識性能が向上するが、演算量やパラメーターが増え、大量の電力を必要とする。現状ではクラウド上で利用されることが多いが、スマートフォンや車載用デバイスに高度なAI技術を搭載して高精度の処理を高速で行うには、ディープラーニングモデルを軽量化することが求められる。

今回新たに開発された軽量化技術は、OKIが独自開発したチャネルプルーニング技術であるPCAS(Pruning Channels with Attention Statics)を発展させたもので、認識性能を維持したままで演算量を約80%削減できるという。

チャネルプルーニング技術とは、フィルターとの畳み込み演算結果を保持するニューロンである「チャネル」のなかで、冗長なニューロンに関する係数や演算を削減して軽量化する技術のこと。従来は、手間がかかり、全体として削減量を最適化することが困難という課題があった。

そこで、画像や自然言語などの認識にとって重要な情報に着目する手法である「アテンション」モジュールを採用することより、認識性能を低下させることなく、層単位の削減率設定を不要とした。層間にアテンションモジュール挿入して後段の層への情報伝達を抑制し、モデル全体の推論誤差を最小にする学習を行うことで、重要度推定を最適化するという。

NEDOとOKIは、革新的AIエッジコンピューティング技術の開発等のNEDO事業において、モデル軽量化技術の開発を目指してきた。両者は今後、今回の軽量化技術の高度化・高効率化や大規模な認識モデルへの導入を進めていくほか、消費電力を抑えつつ高度なAIを実行できる技術を確立したいとしている。(記事:Kei_T・記事一覧を見る)

スポンサードリンク

スポンサードリンク

- Google、超リアルな動画生成AI「Lumiere」を発表 1/31 15:40

- AmazonのFire TVシリーズ、画像生成AIによる壁紙機能が追加 1/26 09:13

- Chromeに新たなAI機能、タブの自動整理や文章作成支援など 1/26 09:10

- Fairly Trained始動、学習データを無断使用しない生成AIに認定証を授与 1/21 17:37

- 生成AIが書いた論文を瞬時に判定する「生成AIチェッカー」、ユーザーローカル 1/19 16:39