関連記事

深層学習をリードする日本発ベンチャーPFN、学習速度で世界最速を実現

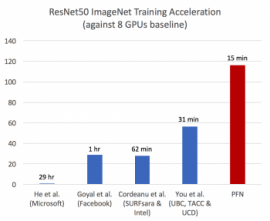

「ImageNet」を利用した学習速度の比較(写真:PFN発表資料より)[写真拡大]

Preferred Networks(PFN)は10日、大規模な並列コンピュータ「MN-1」と分散深層学習「ChainerMN」を用いて、深層学習(ディープラーニング)の学習速度において世界最速を実現したと発表した。

【こちらも】部品交換をIoTで最適化 三菱電機、鉄道車両の予防保全システム開発へ

PFNは、IoT(Internet of Things)と人工知能(AI)を融合させたイノベーションを起こすことを目指して2014年に創業。デバイスが生み出す膨大なデータを、ネットワークのエッジで分散協調的に処理する「エッジヘビーコンピューティング」を提唱し、交通システム、製造業、バイオ・ヘルスケアの3つの事業領域で、トヨタ、ファナック、国立がん研究センターなどと協業しながらイノベーションの実現を目指している。

協業先は日本だけではない。インテルとPFNは4月6日、PFNが開発・提供する深層学習向けオープンソースフレームワーク「Chainer」の開発で協業すると発表。また、マイクロソフトとPFNは5月23日、人工知能や深層学習の実社会での活用を推進するため、戦略的協業することで合意したと発表している。

●ベンチマークデータと結果

深層学習の速度判定についてはさまざまな基準があるが、一般に広く使われている画像分類データセットであるImageNetのResNet-50ベンチマークデータを使用した。

深層学習の研究開発用プライベート・スーパーコンピュータ「MN-1」と、分散学習パッケージ「ChainerMN」を用いて学習させたところ、15分で学習を完了。計算ノードにはNVIDIAの「Tesla P100 GPU」を1,024基搭載している。

今までの最高性能が、インテル「Xeon Platinum 8160」を1,600基搭載したコンピュータでの31分であったので、2倍の高速化を達成したこととなる。

●「MN-1」とは

深層学習の精度を追及すると、学習データのサイズや量が増大。伴い計算時間も増大し、1回の学習に数週間かかることも稀ではない。複数のコンピュータを連携させて学習を高速化することは、素早く研究成果をあげていくために重要だ。

一方、複数のコンピュータを使った並列分散学習では、GPU間の通信にオーバーヘッドにより、GPU数に比例するような成果が望めないという課題があるという。

このオーバーヘッドを解決するために、NTTコミュニケーションズの高速演算処理(GPU)プラットフォームとNVIDIAの「Tesla P100 GPU」を1,024基搭載した「MN-1」を開発した。理論上のピーク性能は4.7ペタフロップス(1ペタフロップスは毎秒1,000兆回の浮動小数点演算を行える能力)であり、民間企業のプライベートな計算環境として、国内最大級だという。

●ChainerMN(分散深層学習)とは

PFNが中心となって開発・提供するChainerは、“Define-by-Run”の手法を通じて簡単かつ直感的に複雑な深層学習を設計できる環境である。2015年6月にオープンソース化され、最も普及している深層学習向けフレームワークの1つである。

Chainerは、最新の深層学習研究の成果を迅速に取り入れており、分散深層学習のChainerMN、強化学習のChainerRL、コンピュータ・ビジョンのChainerCVなどの追加パッケージがある。(記事:小池豊・記事一覧を見る)

スポンサードリンク

関連キーワード

スポンサードリンク

- 怒りを「紙に書き」「丸めて捨てる」と怒りが静まる 名大らが確認 4/13 08:51

- 量子もつれの情報伝達速度には限界があった 京大らの研究

4/ 6 16:31

4/ 6 16:31 - 全身性強皮症に抗酸化サプリが有効な可能性 ルイ・パストゥール医学研究センター

4/ 5 09:06

4/ 5 09:06 - DNAの切断を修復する仕組み解明 がんの原因解明・治療に期待 東大ら

3/22 19:19

3/22 19:19 - 日本周辺海域の魚類が小型化 地球温暖化の影響 東大

3/ 5 09:15

3/ 5 09:15